Auf Anregung von Besuchern meiner Homepage habe ich die Links für die Abbildungen in allen Lehrheften verändert:

Beim Aufrufen einer Abbildung öffnen Sie ein neues Fenster mit dem ausgewählten Bild. Um zur Textseite zurückzukehren müssen Sie dieses zweite Fenster entweder schließen oder zur Seite ziehen. Falls Sie die zweite Möglichkeit benutzen, wird das erste Bild beim erneuten Aufruf einer weiteren Abbildung überschrieben u.s.w.. Mit den Befehlen „vor“ und „zurück“ im aktuellen Bildfenster können die anderen, schon ausgewählten Abbildungen immer wieder aufgerufen werden. Rückkehr zur Textseite ist durch Anklicken dieser immer möglich.

Klangselektion:

Vielleicht ist die Einleitung zu meinem vierten Lehrheft etwas unorthodox, vielleicht erleichtert sie aber dadurch das Verständnis des Begriffs „Klangselektion“, mit dem ich mich im Folgenden befassen möchte. Vom 3. bis 5. Mai 2001 führte die Deutsche Akademie für Sprache und Dichtung in Freiburg i. Bsg. ihre Frühjahrstagung durch. Thema: Musik zur Sprache gebracht, Sprache zur Musik gebracht. Die Vorträge waren historisch und rhetorisch brilliant, doch haben sie mich thematisch nicht befriedigt. Beschränke ich mich auf den Titel „Sprache zur Musik gebracht“, so hätte man vielleicht besser „Sprache über Musik“ ausgewählt. Es war jedoch gerade diese Tatsache, die mich zum besonderen Nachdenken anregte, ist doch die Analyse und damit die Klangselektion mit eine Lösung des Themas: Sprache zur Musik gebracht. Hierzu ein paar grundlegende Gedanken.

Das Problem beginnt im physikalischen Bereich. Ich zitiere Juan G. Roederer1:

„Im Laufe der Entwicklung entstand eine höchst bemerkenswerte Aufgabenteilung zwischen den beiden Hirnhälften. Die linke Hemisphäre (bei etwa 97% aller Menschen) führt vor allem kurzzeitig aufeinanderfolgende Vorgänge aus, wie sie zur verbalen Verständigung und zum Denken erforderlich sind. Der rechten Hemisphäre obliegt die Verarbeitung räumlicher Integrierung und länger dauernder Darstellungen. Beispiele für diese holistischen Vorgänge in der rechten Hemisphäre sind bildliche Vorstellungsvermögen und die Wahrnehmung von Musik.“ (Zitatende)

Beide Hemisphären sind durch einen Balken (Reizleitungen) mit ca. 200 Millionen Fasern verbunden, es entsteht eine globale Einheit des Abbilds der Umwelt. Neue Forschungsergebnisse sagen z.B. aus, dass Kinder zuerst singen und erst danach das Sprechen erlernen. Ich möchte mich nun nicht in teils unterschiedlichen physikalischen Ergebnissen verlieren, sondern meine persönlichen Erfahrungen, Empfindungen als Musiker in einem Satz formulieren:

Für mich sind Sprache und Musik von ihrem Klangmaterial her gleich, sie unterscheiden sich nur in ihren informativen Vorgängen und deren Verarbeitung.

Typisch hierfür ist für mich die Instrumentalisierung der Sprache, z.B. in der Chormusik von Johann Sebastian Bach. Ich denke dabei vor allem an seine Chor-Fugen, auch dann, wenn sie a-cappella gesungen werden. Da meist die Textverständlichkeit (außer in der Exposition) der instrumentalen Polyfonie weichen muss, verändert sich damit auch die sprachliche Information. Diese kann vielfach nur über Textdruck im Programmheft vervollständigt werden.

Das Klangmaterial der Sprache und der musikalischen Instrumente, und darum geht es mir bei der Klangsektion, ist gleich, d.h. die Formantbereiche der meisten Vokale und Konsonanten, sowie die der Musikinstrumente (ausgenommen z.B. Schlaginstrumente oder Glocken) entsprechen dem ganzzahligen Vielfachen des Grundtons (Teiltonreihe). Abbildungen eins und zwei zeigen eine Spektralanalyse der Vokale A und E. Wir können aus dieser Analyse ersehen, dass das Teiltonverhältnis der Vokale wie bei den meisten Instrumenten aus dem genannten ganzzahligen Vielfachen besteht. Die Frequenz 791 Hz im Bild des Vokals „A“ ist durch eine kleine nichtlineare Verzerrung bei der Überspielung in den Computer entstanden. Außerdem sind bei der digitalen Analyse kleine Frequenzabweichungen (Auslesegeschwindigkeit des Rechners) möglich, die jedoch für die Aussage über das Teiltonverhältnis keine Bedeutung haben. Vokal A ist von 0 bis 2000 Hz, Vokal E von 0 bis 3000 Herz dargestellt. Ich habe diese Auflösung zum besseren Lesen auch bei kleineren Bildschirmen ausgewählt.

Abbildung 1

Abbildung 2

Weitere Stationen auf meinem Weg zur zuvor genannten Beurteilung von Musik und Sprache sind Beispiele aus der Literatur. Vor allem beim Lesen von Gedichten französischer Dichter des 19. Jhd., Paul Verlaine und Arthur Rimbaud, habe ich oft das Gefühl gehabt, nicht Sprache sondern Musik wahrzunehmen. In einer französischen Literaturgeschichte2 steht über die späteren Arbeiten von Verlaine:

In den Romances sans Paroles wandte Verlaine erstmals die Theorie der eigenen Form an, die er in einem später (1884) veröffentlichen Gedicht Art poétique niedergelegt hat: „Der Vers soll Musik sein, eine Harmonie von Tönen, ein flüchtiger Rausch, der die Grenzen der Form verwischt und die Farben nur als Abschattungen kennt.“

Ein weiteres Beispiel aus dem täglichen Leben:

Wenn bei einer Bahnfahrt ausländische Fahrgäste, deren Sprache ich nicht verstand, mit im Abteil saßen, habe ich ihr Sprechen als Gesang empfunden. Die Unkenntnis der Sprache haben meine Informationsverarbeitung verändert, umgewandelt.

Mit besonderem Interesse hörte ich vor wenigen Tagen anläßlich eines Symposiums der Freiburger Albert-Ludwig-Unversität, Musikwissenschaftliches Seminar (Prof. Dr. Christian Berger), einen Vortrag von Frau Prof. Dr. Gretel Schwörer-Kohl, Halle, über „Musik als Kommunikation mit dem Jenseits am Beispiel von Mundorgelkompositionen der Hmong in Nordthailand“. Das Urvolk der Hmong hat laut Legende alle Schriften verloren. Um sich weiterhin verbal bei Zeremonien für Verstorbene ausdrücken zu können, wurde ein musikalisches System kreiert, das Worte und bestimmte Laute in Tonhöhen umwandelte. Dies bedeutet, dass einem Wort eine feste Tonhöhe zugeordnet wird, so dass aus der Folge von gespielten Tönen der zuvor geschulte Zuhörer verbale Informationen erkennen kann: „Musik wird zur Sprache“.

Abbildung 3

Noch viele Beispiele wären zu nennen, doch möchte ich mich nicht zu lange in Gedanken über das Verhältnis Sprache - Musik verlieren und zu meinem eigentlichen Thema zurückkommen.

Klangselektion heißt Klanganalyse. In meinem Heft 1 „Vocoder“ habe ich schon ausführlich über Sprachanalysen gesprochen. Eine Analyse entsteht durch Selektion eines komplexen Klanges in seine einzelnen Frequenzbereiche, wir versuchen sozusagen, in das Innere eines Klanges einzudringen. Diese Selektion wird mittels Filter erreicht. In der nachstehenden Abbildung habe ich nochmals die für eine Klangselektion wichtigsten Filter aufgezeigt , wobei eine Selektion meistens mit Bandpassfiltern realisiert wird.

Abbildung 4

Zum besseren Verständnis möchte ich nochmals kurz die unterschiedlichen Filterfunktionen und das daraus resultierende, für den Musiker wichtige Klangergebnis ansprechen: Die blau punktierten Flächen in Abb. 4 sind Klanganteile, die das Filter unverändert passieren läßt (Durchlassbereich). Die rot schraffierten Flächen stellen Grenzzonen dieser Bereiche (Flanken) dar, deren Größe (Winkel) uns die Qualität eines Filters, seine Selektionsschärfe, vermittelt. Je steiler diese Flanken sind (Flankensteilheit), um so klarer wird z.B. die blau punktierte Zone eines Bandpasses akustisch abgegrenzt. Der Tiefpass hat eine obere Grenzfrequenz, der Hochpass eine untere Grenzfrequenz und der Bandpass eine Mittelfrequenz (siehe Abb. 4). Grenzfrequenzen und Mittelfrequenz haben eine variable Größe und können vom Komponisten bestimmt werden. Die Bandbreite eines Bandpasses ist vom Filtertyp abhängig:

261 Hz3 - 523 Hz = Oktavfilter

261 Hz - 392 Hz = Quintfilter

261 Hz - 329 Hz = Terzfilter

261 Hz - 293 Hz = Sekundfilter

Die Filtercharakteristiken können einzeln oder kombiniert eingesetzt werden. So ergibt z.B. die Kombination von Tief- und Hochpass einen Sperrfilter (siehe Abb. 4).

Ausgehend vom Klangspektrum der normalen Instrumente und Singstimmen, auch vom Hörvermögen unserer Ohren, kann angenommen werden, dass das gesamte Frequenzspektrum eines Filters eine Breite von 30 Hz bis 18000 Hz aufweist. Soweit eine kleine technische Exkursion.

Nach meinen am Anfang dieses Heftes angesprochenen Fragen über Sprache und Musik werde ich folgerichtig mit der Selektion von Sprache beginnen. Die ersten Analysen dazu habe ich bereits in den Abbildungen 1 und 2 dargestellt und darauf hingewiesen, dass jeder Klang aus einer Teiltonreihe mit charakteristischen Tonhöhenbereichen - den Formanten - besteht. In dem folgenden Klangbeispiel habe ich aus den Worten „Sprache zur Musik gebracht“ jeweils einen Vokalformant heraus selektiert. Es sind dabei natürlich Tonhöhen-Überschneidungen mit anderen Vokalen oder Konsonanten nicht zu vermeiden, sodass der Text immer ein wenig verständlich bleibt, obgleich der Formantbereich im Vordergrund zu hören ist. Wie in Abbildung 4 zu sehen ist, sind die Flanken eines Bandpassfilters (auch andere Filterarten) nicht senkrecht, d.h. angrenzende Tonhöhenbereiche werden noch leise wahrgenommen. Diese „Flankensteilheit“, sie bestimmt wie zuvor gesagt mit die Qualität eines Filters4, sie sollte für unsere Zwecke nicht unter 60 dB pro Oktave liegen. Hören wir Klangbeispiel eins. Ich spreche den zuvor genannten Text fünfmal: 1. original, 2. Vokal A selektiert, 3. Vokal U selektiert, 4. Vokal E selektiert und 5. Konsonant S selektiert. Bitte das Beispiel nicht zu leise abhören, da die Dynamik schon infolge des Ausfilterns reduziert ist.

Klangbeispiel 1

Beim Anhören der selektierten Beispiele konnten wir feststellen, dass ein gewisser Rhythmus entsteht, vor allem beim Konsonanten S5 . Wenn ich nun ein Gate6 anstatt mit einem Mikrofon (Steuereingang) mit dem selektierten S kontrolliere, dann wird dieser Rhythmus auf eine andere Klangfunktion übertragen. So kann z.B. das Aufblenden eines Verzögerungsgerätes - ich werde im 2. Teil dieses Heftes nochmals darauf zurückkommen - in einem aus Selektion von Sprache erzeugten Rhythmus realisiert werden, die Sprachselektion erhält eine kompositorische Funktion, die aufgrund von Interpretationsunterschieden gleichzeitig einem Zufall unterliegt. In einem weiteren Klangbeispiel habe ich versucht, den Inhalt des Satzes „Sprache zur Musik gebracht“ klanglich zu verwirklichen, Sprache in Musik umzuwandeln, wobei das Tonmaterial ausschließlich aus dem Klang der Sprache selektiert ist.

Und wie funktioniert das: Aus der Sprache habe ich mit einer Sekund-Filterbank (48 Bandpässe mit einem Tonhöhenbereich von der Bandbreite einer musikalischen Sekunde) in einer bestimmten Folge einzelne Klangbereiche selektiert, diese verzögert und mit Nachhall verlängert wiedergegeben, zusätzlich durch ein Feedback verdichtet. So entstand aus der Sprache eine Komposition, deren Form durch den Sprachrhythmus, die unterschiedlich ausgefilterten Tonhöhenbereiche und den live-elektronischen Mitteln wie Nachhall und Verzögerung definiert ist. Leider muss dieses Klangbeispiel in einer Internetversion relativ kurz sein, um die Zeit für das Herunterladen (Download) zu begrenzen.

Klangbeispiel 2

Luigi Nono hat in besonderer Weise die Sprachselektion in seinem „Prometeo“ eingesetzt. Die beiden Sprecher, eine weibliche und eine männliche Stimme, sind im Prologo7 nur selten direkt zu verstehen, meist können wir den Sprachrhythmus nur aufgrund einzelner, selektierter Sprachformanten erkennen, wobei diese verschiedenen Selektionen immer mit einem Klangortswechsel (Lautsprecher) verbunden sind. Nono will keine akustischen „Erzähler“. Durch die Klangselektion, verbunden mit der Funktion eines umgebenden, quasi einhüllenden Klangraumes - und da außerdem nur wenige Zuhörer den altgriechischenText verstehen können - verliert die Sprache zum Teil ihren ihr eigenen informellen Charakter. Sie erhält diesen, wenn auch unvollständig und mehr gefühlsmäßig, aus der Synthese mit der kompositorischen Ausage der Instumental- und Vokalstimmen (Chor) zurück. Die selektierte Sprache verschmilzt als „Instrument“ klanglich und formell in der großartigen Klanggestalt dieser Komposition.

Prometeo, Isola 2, 2.Teil: Schicksalslied. Text: dritte Strophe original von Hölderlins gleichnamiger Dichtung. Nono hat wieder die Klangselektion eingesetzt, doch dieses Mal nicht durch Selektion mit Bandpassfiltern, sondern als kompositorische Form, wiederum für zwei Sprecher. Dazu zum besseren Verständnis eine kurze Einführung in den formalen Aufbau dieses Kompositionsabschnittes:

Schon mit der Besetzung - 2 Soprane, Bassflöte, Kontrabassklarinette, 2 Sprecher und Elektronische Klangumwandlung - dokumentiert Nono Hölderlins persönliche Aussage in seiner Dichtung8 : Verhüllend - enthüllend, gegensätzliche Denkweise - negativ und positiv. Der Germanist und Musikologe G. Schnitzler sagte in seinem in Fußnote 8 genannten Vortrag: „In der dritten Strophe seines Schicksalsliedes spüren wir den Fall des Dichters in das Ungewisse“. Nonos Besetzung, sehr hohe und sehr tiefe Stimmen, ist absolut gegensätzlich, ebenfalls der kompositorische Entwurf selbst. Während der Text für die beiden Sopranstimmen durch Kantilenen von langen Noten oder mehr längeren rhythmischen Phrasen unterlegt ist, werden die Konsonanten der Worte besonders hervorgehoben, akzentuiert (Sprachselektion). Dieser akustische Vorgang wird zusätzlich durch eine elektronische Verzögerung mit Schichtung (Feedback) hervorgehoben. Die Bassflötentöne und teilweise Rosa Rauschen steuern im Vocoder den Klang der Kontrabassklarinette invertiert, d.h. spielt die Flöte in tiefen Lagen, so werden die Töne der Klarinette nach oben transponiert9 . Hinzu kommen sehr große dynamische Unterschiede von pp bis fff, quasi Sforzati. Nono sagte mir bei den Proben zur Uraufführung:

„Mache den Klang der Bläser und des Vocoders messerscharf (daher auch bei Höhepunkten zusätzlich gesteuertes Rauschen). Er muß die Kantilenen der Soprane zerschneiden“.

Ungefähr in der Mitte der Komposition beginnen die beiden Sprecher mit dem Originaltext in ungewöhnlicher Betonung, siehe Abbildung 5. Wiederum tritt die Verständlichkeit des Textes durch dieses Hervorheben von Vokalen, Konsonanten und Silben in den Hintergrund. Eine „Klangselektion“ nicht mittels Bandpassfiltern, sondern durch entsprechende Betonung und Phrasierung auskomponiert.

Abbildung 5

Vor dem Wechsel von der Sprache zur Musik nochmals eine kurze technische Exkursion: Die digitale Bauweise der heutigen Universalfilter erlaubt eine variantenreiche Ansteuerung. Dazu muss ein Filter jedoch eine entsprechende Software haben. Über Midi-Kontrolle können z.B. Filter-Ablaufsequenzen vorprogrammiert werden, d.h. das Öffnen einzelner Bandpässe erfolgt nach einer kompositorisch erdachten Reihenfolge oder mit einer automatischen Zufallssteuerung. Eine weitere wichtige und sehr interessante Funktion ist ein Freezing-Programm.

Abbildung 6

Mittels eines Triggersignals - z.B. manuelle oder akustische Auslöseimpulse (Instrumente, Stimmen) - wird das Momentanspektrum eines komplexen Klanges, Eingang A, festgehalten (eingefroren). Die aus diesem Analysevorgang gewonnene Filterkombination wird dann zu einem späteren Zeitpunkt als Klangselektion für ein neues Signal, Eingang B, verwendet. Dies bedeutet, dass die einzelnen Tonhöhenbereiche von Klang A auf Klang B übertragen werden. Voraussetzung ist in diesem Fall ein ähnlich breites Klangspektrum der beiden Klänge A und B.

Gerade die zuletzt genannte Filterfunktion zeigt, dass für die gesamte Klangselektion eine genaue Kenntnis des Klangspektrums eines verwendeten Materials, z.B. Instrumental- oder Vokalstimmen, Voraussetzung ist.

So steht am Anfang des Komponierens mit Klangselektion die Klanganalyse. Die Technik der Analyse ist leider in den Ausbildungsstätten der jungen Komponisten nur wenig vorgedrungen. Erstaunlich, denn gerade für die modernen Wissenschaften ist die Analyse von großer Wichigkeit.

Was sind aber die eigentlichen Schwierigkeiten, die z. B. Physik und Musik voneinander trennen, zumindest das Verstehen erschweren? Innerhalb der Physik sind die Grundlagen für alle Arbeiten die physikalischen Gesetze. Wir stehen vor einem Formelberg. Die Komplexität einer gehörten Schwingung ist so groß, dass es für einen Nichtphysiker mühselig ist, die für eine Analyse notwendigen physikalischen Gesetze aneinander zu reihen. Und doch frage ich mich, inwieweit beim Stand der heutigen Technik mit ihren fantastischen Analysatoren dieses Problem noch vorhanden ist. Nahezu alle Komponisten der jüngeren Generation, die ich kenne, sind perfekte Informatiker, zumindest verstehen sie mit Software umzugehen. Warum dann nicht auch mit digitalen Analysatoren? Alle Computer, die zum heutigen Komponieren verwendet werden, sind mit einem Audiosystem ausgerüstet. Damit ist auch die Voraussetzung geschaffen, eine gute Analyse-Software zu installieren, die zuvor genannten Schwierigkeiten können wir vergessen. Ein Komponist muss für seine Arbeit mit dem neuen Instrument „Elektronische Klangumformung, Klangerweiterung“ den speziellen Klang eines Instruments, einer Singstimme und deren spektrale Zusammensetzung genau studieren, um sinnvoll damit und dafür komponieren zu können. Es genügt hierfür nicht immer eine empirische Kenntnis. Mit einem Bandpass kann man einen beliebig breiten Tonhöhensektor aus einem Gesamtklang herausschneiden und damit den Charakter des Originaltons abschwächen, in gegebenem Fall die Klangfarbe ganz entpersonifizieren, neutralisieren. Ein Vorgang, der vor allem dann wirkungsvoll sein kann, wenn der selektierte Tonbereich mit einer Formantregion10 identisch ist. Umgekehrt lässt sich der ebengenannte ausgefilterte Tonbereich verstärken und dem Originalton in Echtzeit beimischen - eine andere, neue Klangfarbe ensteht. Es ist nicht zu vermeiden, dass es zwischen dem selektierten Tonbereich und dem Originalton zu Phasenverschiebungen kommt. Was vielleicht messtechnisch als Mangel angesehen wird, ist für die Elektronische Klangerweiterung, die Klangselektion eine musikalische Klanggestalt, ein neues Instrument, das eine bessere Klangortsbestimmung erlaubt. Auch für die Klangfarbe selbst kann diese Phasenverschiebung11 sehr wirkungsvoll sein.

Luigi Nono hat in seinen Werken „GUAI AI GELIDI MOSTRI“ und „PROMETEO“ diese Technik für ein Streichtrio eingesetzt und damit, obwohl vom Streichinstrumentenklang abhängig,ein unwirkliches, von ihm erdachtes Klangkontinuum geschaffen, dessen einem Phasing naher Klang durch die Live-Interpretation immer lebendig, spannend und trotzdem sehr mystisch bleibt. Einzelne Teile dieses Klangkontinuums werden zusätzlich noch verzögert und geschichtet (Feedback). Dadurch erreicht Nono zum einen seinen speziellen Choreffekt (Nono: “zu entdecken andere Räume, andere Phantasien“), zum andern kann das Streicherkontinuum bei geschlossenem Eingang des Verzögerungsgerätes (vor allem während FFFF der Bläser) klanglich über längere Zeit gehalten werden.

Abbildung 7

Am linken Rand stehen die Filter-Angaben, im Bild Kombination 1.

Selektiere ich z.B. aus einem Instrumentalsolo eine große Sekunde 740 Hz - 830 Hz, so ist dieser Tonhöhenbereich immer dann unter den genannten Bedingungen hervorgehoben, wenn das Instrument ein g2 spielt. Ein ähnliches Beispiel habe ich schon bei der Sprach-Klangselektion besprochen.

Abbildung 8

Auch einzelne Teiltöne können, soweit vorhanden, entsprechend ihrer Amplitude innerhalb des Gesamtklangs verstärkt werden. Im unserem Beispiel (Abb. 8) wäre dies bei einem Ton g1 der zweite Teilton.

Wenn nun der Ausgang des Bandpass-Filters mit Eingang 1 und ein Sinusoszillator (622 Hz) mit Eingang 2 eines Ringmodulators verbunden werden, wird der in Abb. 8 gezeigte Effekt durch das Klangergebnis des Rgm 783 Hz + 622 Hz und 783 Hz - 622 Hz noch intensiver, noch origineller.

Abbildung 9

Verfolgt man den Ablauf des Instrumentalsolos Abb. 8 und seine rhythmische Reihe, so entsteht zusätzlich zur Klangerweiterung eine neue rhythmische Funktion, die der Komponist im weiteren Verlauf seiner Arbeit in seine Komposition integrieren kann. Das ursprünglich erdachte Klangspiel erhält eine formale Bedeutung. Selbstverständlich kann das selektierte Signal auch als Steuersignal für andere klangumformende Funktionen abgerufen werden, quasi als ein Triggersignal oder Midibefehl. Es ist sehr wichtig, dass für das zuletzt genannte Beispiel ein nicht sehr teiltonreiches Instrument (z.B. Flöte) ausgewählt und damit die Selektion akustisch klarer abgegrenzt wird.

Abbildung 10

Wenn im Folgenden 6 Bandpässe eingesetzt werden, so ist das klangliche Ergebnis noch farbiger, wobei die Variationsbreite vom Tonumfang, Form und Tempo des Instrumentalsolos immer abhängig ist.

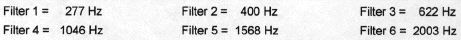

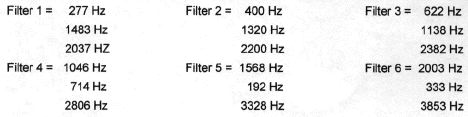

Die Mittelfrequenzen der Filter sind:

Damit ist die Tonreihe der Filterreihe (Mittelfrequenzen):

Mit diesen 6 Frequenzbereichen sind die gleichen Steuervorgänge, wie zuletzt genannt, möglich (siehe Abb. 8).

Wird nun der Ausgang der Filterbank wieder mit einem Rgm verbunden und Eingang 2 des Modulators mit einem Sinusoszillator (vgl. Abb.9) verbunden, so entstehen folgende meist aus Mikrointervallen zusammengesetzte schnelle Tonfolgen (auch Akkorde, vom Tempo abhängig):

Wie gesagt, diese Angaben sind rein rechnerisch, das klangliche Ergebnis ist, wie gesagt, von mehreren Komponenten wie Klangfarbe, Dynmik und Tempo des gespielten Soloinstrumentes abhängig, auch von der Qualität der Sekund-Filterbank. Dem Komponisten stehen viele Variationsmöglichkeiten zur Verfügung. Mit unterschiedlich programmierten Filterkombinationen kann man das Klangergebnis beeinflussen, auch mit Sequenzen, vorprogrammiert, manuell oder von einem Zufallsgenerator ausgelöst. Selektiert man gesprochene Sprache, so wird, wie schon zuvor, eine sehr interessante Klangfolge hörbar. Aufgrund des teils komplizierten Sprachrhythmus ist es verständlich, wenn am Ausgang der Filterbank ein rhythmisch und akkordlich sehr differenziertes Tongemisch entsteht.

Die in den Abbildungen 8, 9 und 10 gezeigten Kombinationen sind frei erdacht und sollen zum eigenen Experimentieren anregen.

Es folgen nun ein paar Beispiele aus Kompositionen, die im Experimentalstudio der Heinrich-Strobel-Stiftung des SWR in Freiburg entstanden sind:

„...explosante fixe...“, für acht Instrumente und Elektronische Klangumformung von Pierre Boulez, haben wir am 6. Januar 1973 in der Alice Tully Hall im Lincoln Center in New York uraufgeführt. Die erste von 20 Sequenzen dieses Werkes ist ein großes Flötensolo. Boulez hat mittels 6 Bandpassfiltern einzelne Frequenzbereiche selektiert und punktförmig über Lautsprecher in den Konzertsaal eingespielt. Es handelte sich nicht um eine normale Klangverstärkung des Flötentones, sondern um ein quasi partielles Echo im Raum. Damit hat Boulez zum einen, wie schon zuvor erwähnt, einen neuen zusätzlichen Rhythmus, zum anderen eine neue Qualität des Klangraumes kreiert, die beide aus dem Entwurf seiner Komposition heraus in Verbindung mit Live-Elektronik entstanden sind. Dieses Beispiel zeigt deutlich, dass die Verbindung unterschiedlicher Elemente der Elektronischen Klangumformung, Klangerweiterung, in gegebenem Fall Klangselektion - Raumklang, wieder zu neuen Klangstrukturen, Klangräumen führt.

Abbildung 11

Auch im nächsten Beispiel finden wir die Kombination unterschiedlicher Live-Elektronik-Funktionen, gleichzeitig beginne ich mit diesem Beispiel den zweiten Abschnitt dieses Heftes:

Klangsteuerung

Kasimierz Serocki hat in seiner „Pianophonie“ für Soloklavier, Elektronische Klangumformung und Orchester12 eine Klavierkadenz auskomponiert.

Die Kadenz beginnt mit einer zweifachen Verzögerung, 9 und 16 Sekunden.

Abbildung 12

Ein einfaches digitales Verzögerungsgerät erlaubt heute die zeitversetzte Wiedergabe eines akustischen Signals zwischen 0,02 ms und ca. 20 Sekunden pro Kanal. Natürlich können diese Zeiten je nach Umfang der Speicherkapazität eines Computers vergrößert werden, doch für den musikalischen Bereich sind 20 Sekunden schon eine lange Zeitspanne. Aufgrund dieser relativ großen Dauer haben diese Verzögerungszeiten mit einer einfachen kanonischen Wiederholung nichts mehr zu tun, der Komponist kann damit neue Zeiträume erschließen.

Abbildung 13

Die Regler R3 und R4 des digitalen Gerätes sind zur Kontrolle der Schichtung (Feedback).

Kehren wir wieder zurück zur Kadenz von K. Serocki, Abb. 12. In dieser Komposition haben wir es noch mit zwei kanonischen Wiederholungen zu tun. In der Abbildung sind diese ersten kanonischen Einsätze eingetragen, damit der Pianist sein Spieltempo überprüfen kann. Aufgrund der Verbindung mit einer genau definierten Klangselektion - die Bandpässe (Quintfilter) sind auf den beiden Klangregiezeilen (KR) eingetragen - geht allerdings der Charakter des Kanonischen verloren, man hört in der Zeitverzögerung ein ähnliches, aber doch anderes, örtlich entferntes Instrument. Das entfernte Hören wird durch die Position der Lautsprecher kontrolliert. Serocki lässt nun diesen selektierten Klang durch eine stufenweise Veränderung der Filterkombinationen klanglich immer präsenter werden bis zum Erreichen der kanonischen Struktur des originalen Klavierparts. Die zeitliche Verschiebung des Klaviertons in dieser Form entwickelt eine eigene und doch mit dem originalen Klavierspiel verbundene Klanggestalt, einen faszinierenden Zeitraum, der vom Solisten mitgehört und mitgespielt werden muss.

Weitere Funktionen der Klangsteuerung wie Gate, Nachhall etc. habe ich schon in Heft 2 „Raumklang - Klangraum“ beschrieben. Ich möchte mich daher in diesem Teil von Heft 4 in erster Linie mit der Zeitversetzung von akustischen Signalen und deren Kombination mit anderen Funktionen der Elektronischen Klangumformung an Hand von praktischen Beispielen beschäftigen. Schon im Jahr 1970 hat Cristóbal Halffter seine Komposition „NOCHE PASIVA DEL SENTIDO“ für Sopran, zwei Schlagzeuger und Live-Elektronik komponiert. Die Elektronik bezieht sich teilweise auf eine klangliche Zeitversetzung des Schlagzeugklangs, vor allem aber auf die des Sopranpars. Damals stand ihm natürlich noch kein analoges oder digitales Verzögerungsgerät zur Verfügung. So war sein technischer Entwurf in dieser Form schon etwas Außergewöhnliches.

Abbildung 14

Schon während der Proben für die Uraufführung am 10.2.1972 beim Südwestfunk Baden-Baden zeigte es sich, dass die Verzögerung von 10 und 12 Sekunden mittels zwei getrennt aufgestellter Magnetofone nicht möglich war13 . Die beiden Antriebe der Geräte sind nie exakt synchron gelaufen, Jauleffekte waren dadurch nicht vermeidbar. Wir haben daher von der Messtechnik des SWF (Herrn Graf) zwei Magnetofone so modifizieren lassen, dass bei gleichen Verzögerungszeiten, 10 und 12 Sekunden, dieser Jauleffekt weitgehendst vermieden wurde. Lothar Graf sagte : die Lösung kann nur in einem Antriebsmotor liegen und hat dementsprechend dies auch so verwirklicht, wie der technische Umbau dieses Magnetofons zeigt:

Abbildung 15

Halffter hat das verzögerte Signal nicht verändert, doch in Abb. 16 können wir sehen, dass auch er eine kleine und trotzdem klanglich interessante Veränderung festgelegt hat. Der Verzögerungspunkt beginnt erst nach dem Anschlag der Instrumente (siehe roter Strich), so dass der zeitversetzte Klang ohne Einschwingvorgang gehört wird und dadurch einen anderen Charakter erhält. Die schwarz ausgefüllten Mikro-Zeichen bedeuten Mikro zu, entsprechend die anderen Mikro auf.

Abbildung 16

Auf der Basis eines Antriebsaggregats entwickelte Herr Thannheiser aus Villingen im Schwarzwald für das Freiburger Experimentalstudio ein Verzögerungsgerät, das trotz analoger Bauweise schon sehr komfortabel war (siehe Abb. 17 oben). Durch Umschalten der Laufgeschwindigkeit (9,5 cm, 19 cm und 38 cm p.s.) und einer Gleitumlenkrolle konnten Verzögerungszeiten zwischen 1 und 30 Sekunden eingestellt werden. Und es dauerte über 10 Jahre bis das Experimentalstudio 1985 die erste, in seinem Auftrag entwickelte digitale Verzögerung (Abb. 17 unten) in Betrieb nehmen konnte. Immerhin sind sehr große Werke, wie Nonos „Prometeo“ 1984, noch mit der analogen Thannheiser-Verzögerung uraufgeführt worden.

Abbildung 17

Soweit ein kurzer Rückblick auf die Entwicklung der Geräte für die zeitliche Versetzung eines akustischen Signals. Dieser Rückblick ist für mich vor allem im Hinblick auf die Entwicklung der Elektronischen Klangumformung, Klangerweiterung wichtig. Ich möchte fast sagen, dass diese Signalverzögerung mit die meist eingesetzte Funktion innerhalb der Live - Elektronik ist. Ohne eine chronologische Reihenfolge einzuhalten, möchte ich noch wenige Kompositionsbeispiele mit zeitlicher Signalversetzung und deren Verbindung mit anderen klangumformenden Funktionen anfügen.

Es war typisch für Luigi Nonos Arbeit im Studio, dass er in seinem ersten im Studio entstandenen Werk „Das Atmende Klarsein“, 4. Satz, nicht die damals übliche kanonische Form (wie Halffter in NOCHE PASIVA) verwendete, sondern dem Originalton durch die Zeitversetzung eine neue, zusätzliche Klangqualität hinzufügte. Mit zwei Verzögerungzeiten, 1,5 und 3 Sekunden, blendet Nono die lang ausgehaltenen statischen Töne der Flöte im Raum aus. In diese Ausblendung setzt der neue Flötenton ein, so dass kurze überlappende Intervalle aufkommen. Um diesen Klangeffekt richtig auszubilden, müssen - den Atempausen des Musikers entsprechend - die Verzögerungszeiten eventuell geringfügig modifiziert werden. Mit der Zuordnung der Lautsprecher (Abb. 17a, oberer Teil) wird eine sehr leise Klangbewegung erreicht. Es ist unbedingt notwendig, dass von der Klangregie eine einfühlende Dynamikkontrolle erfolgt. Nur dann können diese kurzen Zwischenintervalle zu einer neuen Klanggestalt werden. Die Intervalle habe ich im unteren Teil von Abbildung 17a in ihrer originalen Tonhöhe notiert. Gerade diese kompositorische Aussage der Überlappungsintervalle ist eine der zwingenden Gründe, dass die Flötenstücke, ohne Chorteile aufgeführt, nicht ohne die Elektronische Klangerweiterung im Konzert realisiert werden können.

Abbildung 17a

Dieter Schnebel hat für seine Studien für Klavier und Live-Elektronik zwei Themenbereiche ausgewählt: 1. Teil „Raum“, 2. Teil „Zeit“. Im ersten Teil „Raum“ verwendet der Komponist zuerst den Nachhall, d. h. der Klangraum wird diffuser. Es folgt ein Abschnitt mit zeitlicher Verzögerung des Klaviertons in einer kanonisch-räumlichen Form, wobei durch eine, mit Fußpedal vom Solisten kontrollierte Schichtung auch die kanonische Form immer mehr komplexer und damit unverständlicher wird. Wichtig ist, dass der Solist diese Funktion hört und in seine Interpretation einbezieht. Ein weiterer Abschnitt verbindet nun eine Klangselektion (die Bandpässe sind vom Komponisten festgelegt) mit einem Nachhall. Damit erreicht Schnebel eine zusätzliche Raumtiefe. Schließlich endet dieser Teil mit einem überdimensionierten Nachhall von ca. 100 Sekunden, der langsam bis auf 5 Sekunden reduziert wird: der Komponist holt sozusagen den Klavierton aus einem imaginären Raum in die Wirklichkeit zurück. Im zweiten Teil verwendet Dieter Schnebel ausschließlich nur Signalverzögerung und Klangtransposition. Hierzu möchte ich den Komponisten selbst sprechen lassen:

„Dass ich im Zeitteil der Studien exzessiv mit delay (Verzögerung) arbeite, war für mich insofern wichtig: wenn ich größere Delays habe, von 2 - 3 Sekunden, bekomme ich durch die Wiederholung des Signals in der Verzögerung eine Periode. Was für mich eine wirkliche Entdeckung war, die sich später in ganz neuer Weise sogar im Finale der Sinfonie ausgewirkt hat: Eine Arbeit mit rhythmischen Zellen, ein rhythmisches Motiv - also lediglich lang-kurz oder das Gegenteil kurz-lang - wird auf die Eins gesetzt. Habe ich ein Vierermetrum, was regelmäßig wiederholt wird, dann kommt es natürlich wieder auf Eins. Aber die anderen Zeiten sind noch frei, und ich konnte so etwas auf Drei setzen oder auf Zweieinhalb und so mit dieser Delaytechnik einen Takt vollkommen verschieden ausfüllen. Das finde ich eine ganz aufregende Sache, wobei ich diesen Takt noch ganz aperiodisch struktuieren kann. Durch das Delay entsteht dann wieder eine Periodik des Aperiodischen. Solche Phänomene finde ich sehr faszinierend.“

Abbildung 18 zeigt die Programme für Studien für Klavier und Live-Elektronik von Dieter Schnebel. Alle Kombinationen weisen ein Fußpedal auf, das dem Interpreten zu jedem Zeitpunkt die Möglichkeit gibt, in das live-elektronische Geschehen einzugreifen. Auch die Daten der Bandpassfilter sowie die Transformationsintervalle sind in dieser technischen Legende genau festgelegt.

Abbildung 18

Immer wieder habe ich mir die Frage gestellt, nach welchem Zeitraum die Wiederholung einer musikalischen Vorlage ihren kanonischen Charakter verliert.

Nach zahlreichen persönlichen Versuchen hat sich herauskristallisiert, dass bei einer relativ komplexen Komposition nach ca. 20 Sekunden die kanonische Form unterdrückt wird. Wie gesagt, dies ist natürlich nicht zutreffend, wenn ich nur ein Motiv spiele und dieses nach dieser Dauer wiederhole. Wenn die Wiederholung nun noch klanglich verändert wird, so reduzieren sich die 20 Sekunden um ca. die Hälfte.

Luigi Nono hat für seine Komposition „A Pierre“14 diese langen Zeiten übernommen: das 12 Sekunden verzögerte Originalsignal wird selektiert und mit wenig Nachhall über Lautsprecher eingespielt. Nach weiteren 12 Sekunden wird das originale Signal nochmals, und dieses Mal unverändert, über die gleichen Lautsprecher zugespielt. Aufgrund der langen Verzögerungszeiten ist jede kanonische Form unterdrückt. Bei richtigem akustisch-dynamischen Abgleich soll der Zuhörer nicht mehr unterscheiden können, was die Interpreten spielen und was aus den beiden Lautsprechern eingespielt wird. Klanglich besonders interessant ist die 12 Sekunden-Verzögerung, die mittels Klangselektion, die Bandpässe sind in der technischen Legende genau definiert, in eine akustische Ferne gerückt wird, während nach 24 Sekunden überraschend nochmals der Originalton erklingt.

Abbildung 19

Eine ganz eigenartige Kombination klangumformender Funktionen finden wir bei Cristóbal Halffters „Mizar II“ für zwei Soloflöten, elektronisches Zuspielband und Live-Elektronik15 :

Klangumformung:

1. Klangtransposition (Rgm)

2. Klangverzögerung (Delay)

3. Klangbewegung (Halaphon)

Zuspielband (4-Spur):

1. Erste und zweite Spur = elektronische Klänge

2. Spur 3 = drei Sinustöne, deren Dynamik (Hüllkurven) der vom Komponisten definierten einzublendenden Elektronischen Klangumformung entspricht. Die drei Hüllkurven der Sinustöne steuern über 3 Gates die Elektronische Klangumformung.

3. Spur 4 = ein Impulsgenerator, Frequenz gleich 60 Impulse p. m., zeigt den Solisten über einen Demodulator die Impulsfolge in Zahlen an.

Abbildung 20

Die Trennung der Steuersinustöne erfolgt über drei Bandpassfilter, so dass nur ein Magnetofonkanal verwendet werden muss. Der Impulsgenerator ist quasi als elektronischer Dirigent für die verlangte absolute Synchronisation zwischen Zuspielband und Soloflötisten verantwortlich.

In diesem Beispiel, siehe Abb. 20, sind, wie schon erwähnt, alle Funktionen (außer Vocoder) der Elektronischen Klangerweiterung auf verschiedene Weise eingearbeitet:

Klangtransposition, Klangselektion, Klangraum und Klangsteuerung. Halffter ging es keineswegs um die Einsparung eines Dirigenten, bzw. einer Klangregie. Er wollte eine exakte Klangsteuerung und Synchronität, eine globale Kompositionsform. Natürlich müssen während der Probenarbeit die einzelnen Klangebenen akustisch mit dem Liveklang der Solisten abgeglichen, unter Umständen auch noch in einer Aufführung nachgeregelt werden, so z.B. bei veränderter Saalakustik ohne und mit Publikum. Doch der kompositorische Entwurf bleibt danach in allen Funktionen stabil, d.h. eine möglichst exakte Partitur wird realisiert.

Noch ein letztes Beispiel einer Klangsteuerung mittels Zeitversetzung.

Abbildung 21

Pierre Boulez „...explosante fixe...“, Satz 6, mit Genehmigung des Komponisten von mir für Vibraphon und Elektronische Klangumformung bearbeitet. Der 6. Satz besteht aus einzelnen musikalischen Strukturen, die mit 3.3 / 3.9 / 1.5 und 2.7 Sekunden zeitversetzt werden. Die verzögerten Signale sind teils transponiert (Rgm + Sinus h2) und teils im Raum bewegt. Zusätzlich wird das Vibraphonsignal mit den Intervallen ein Tritonus nach unten und eine Sekunde nach oben statisch mit einem Harmonizer transformiert. Das Produkt eines zweiten Ringmodulators (mit sinus e1) bewegt sich wiederum in zwei Bewegungsformen und -tempi, gleichzeitig das verhallte Signal (15 Sek). Somit ergeben sich 6 unterschiedliche Bewegungsformen mit 6 Bewegungsrichtungen und -zeiten, so dass vollkommen neue Form- und Klangstrukturen entstehen. Diese verändern sich, von Hand kontrolliert, interpretationsabhängig (Musiker und Klangregie) während einer Aufführung, von Konzert zu Konzert . Die Ausgänge der einzelnen Geräte können solo, aber auch mit anderen kombiniert eingesetzt werden. Diese dynamisch manuelle Kontrolle ist für die musikalische Integration der Elektronischen Klangumformung, für den akustischen Abgleich zwischen Instrument und Lautsprecher sehr wichtig und macht, wie schon früher erwähnt, die Klangregie zum musikalischen Partner des oder der Interpreten.

Elektronische Klangumformung, Klangerweiterung ist eine große Bereicherung für das Schaffen neuer Klanggestalten aus den originalen Klangstrukturen des gespielten Instruments.

Klangsteuerung in der Elektronischen Klangumformung bedeutet, wie wir schon in Heft zwei „Raumklang - Klangraum“ gesehen haben, weder Transformation noch Selektion einer Tonquelle. Sie kann für beide eine kontrollierende Funktion übernehmen. Sehr wichtig ist für mich außerdem die Tatsache, dass sich aus geräteeigenem Verhalten neue musikalische Klanggestalten entwickeln können.

Verehrte Leser meiner Website. Soweit die Reihe meiner Lehrhefte. Sollten Sie noch mehr Interesse an diesem Komplex der Live-Elektronik haben, so möchte ich auf meine zweibändige Dokumentation hinweisen. Ein kurzer Bericht über diese Veröffentlichung findet sich am Anfang meiner Website.

.

Ich darf an dieser Stelle nochmals darauf hinweisen, dass für alle live-elektonischen Funktionen der Klangumformung eine genaue Kenntnis der klanglichen Zusammensetzung des originalen Materials (Analyse) zwingend erforderlich ist, wenn eine sinnvolle Integration dieser Elektronischen Klangerweiterung in eine Komposition beabsichtigt wird. Im zweitenTeil des ersten Bandes meiner Dokumentation habe ich darum versucht, die Grundbegriffe der hörbaren Schwingungen für musikalische Nicht-Physiker zu erklären. In allen Heften sprach ich vom Experimentieren. Ich unterscheide zwischen zwei Phasen des Experiments:

1. Phase: Kennenlernen des Instrumentariums für die Elektronische Klangumformung, Klangerweiterung. Ich nenne sie die spielerische Phase.

2. Phase: Sie verlangt einen ersten kompositorischen Entwurf, dessen Besetzung, sei es live-elektronisch, instrumental oder vokal, dann erarbeitet werden muss. Ich nenne sie die kreative Phase.

Ich wünsche allen an der Elektronischen Klangumformung interessierten Komponisten und auch Interpreten viel Freude am Experiment und Erfolg für die kompositorische Arbeit.

1 Juan G. Roederer. „Physikalische und psychoakustische Grundlagen der Musik“. Berlin, Heidelberg, Springer Verlag. 1977, S. 13.

2 Eduard von Jan, Französische Literaturgeschichte. Heidelberg, Verlag Quelle und Meyer, 1961, S. 281.

3 Zur Vereinfachung von Berechnungen und Darstellungen verwende ich für Tonhöhenangaben in Hz keine Stellen nach dem Komma.

4 vgl. Hans Peter Haller, Das Experimentalstudio. Baden-Baden, Verlag Nomos,

1995. Klangselektion, Band 1, S. 55 ff..

5 vgl. Abbildung 4, Klangselektion von Instrumentalklängen.

6 vgl. Heft 2, Klangsteuerung, Gatesteuerung, Abb. 12.

7 Luigi Nono: „Prometeo“, Partitur Verlag Ricordi, Milano. Prolog, Takt 16 ff..

8 Günther Schnitzler, Vortrag anläßlich eines Symposiums der Uni Freiburg, Musikwiss. Seminar.

9 vgl. Heft 1, Vocoder, Abbildung 5.

10 P.-H. Mertens, Die Schumannschen Klangfarbengesetze. Frankfurt a. M..: Verlag E. Bochinsky, 1975

11 vgl. Heft 2 „Klangraum“ in dieser Homepage.

12 Kasimierz Serocki, Pianophonie für Klavier, Elektronische Klangumformung und Orchester. Celle: Verlag Moek, 1976-1978.

13 Auch Stockhausens „Solo“ wurde z.B. aus diesem Grund erst mit der Einführung der digitalen Geräte richtig aufgeführt.

14 Luigi Nono, „A Pierre“ für Kontrabassflöte, Kontrabassklarinette und Elektronische Klangumformung, Pierre Boulez zum 60. Geburtstag, 1986.

15 Cristóbal Halffter, „Mizar“ für 2 Soloflöten, elektronisches Zuspielband und Live-Elektronik. Wien, Verlag UE, 1980.